Begründen und rechtfertigen: Wieviel Transparenz und Erklärbarkeit erfordert die Automatisierung der öffentlichen Verwaltung?

Begründen und rechtfertigen: Wieviel Transparenz und Erklärbarkeit erfordert die Automatisierung der öffentlichen Verwaltung?

Begründen und rechtfertigen: Wieviel Transparenz und Erklärbarkeit erfordert die Automatisierung der öffentlichen Verwaltung?

David Roth-Isigkeit, Dr. iur, M.A., ist seit 2019 Leiter des SOCAI-Zentrums für Soziale Implikationen künstlicher Intelligenz und der Forschungsgruppe „Das Recht der KI" an der Julius-Maximilians-Universität Würzburg. Er beschäftigt sich im Schwerpunkt mit Rechtsfragen der Digitalisierung der öffentlichen Verwaltung.

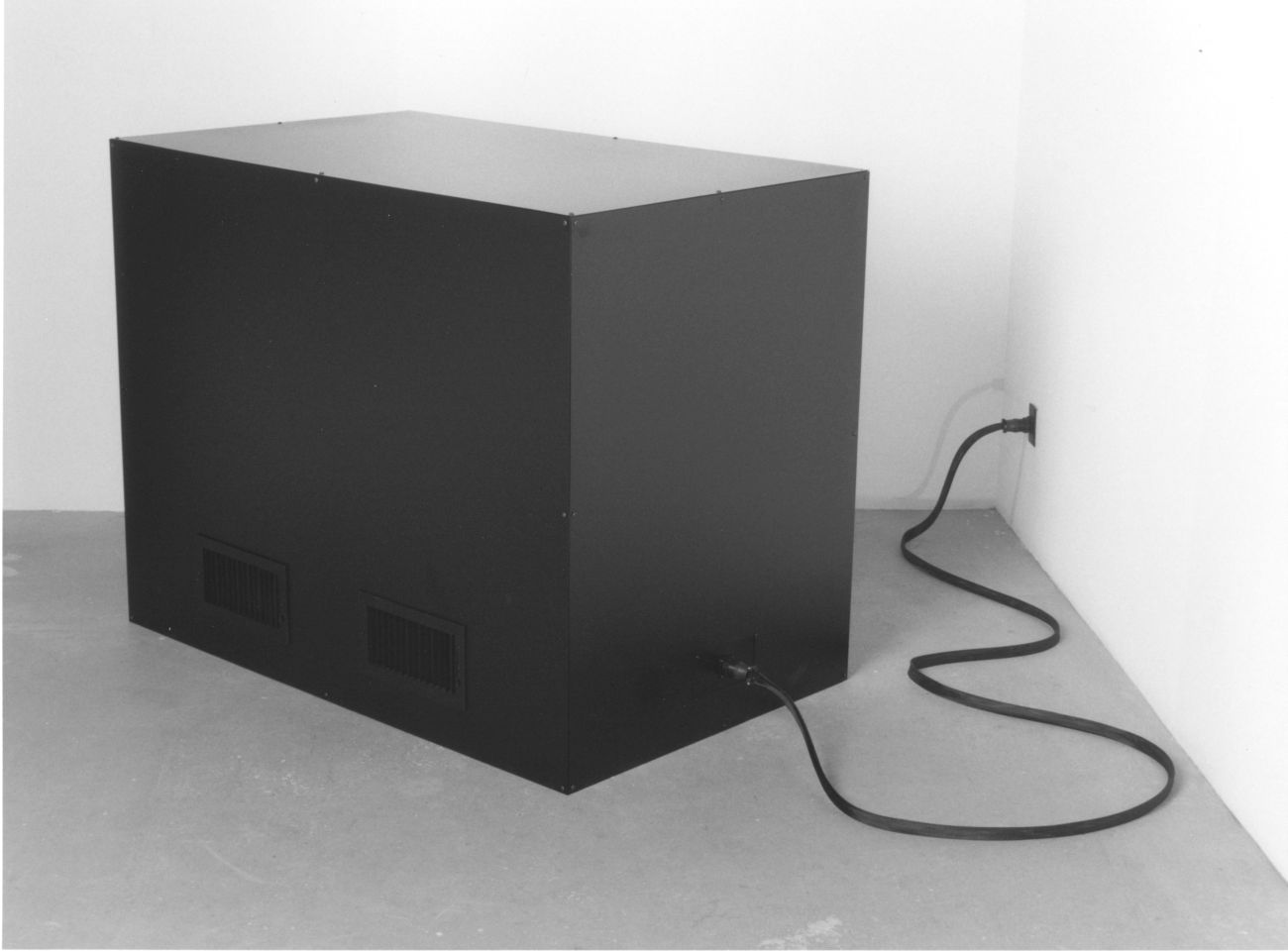

Die sogenannte Computer Says No Dystopie, die vor allem aus der Serie Little Britain bekannt geworden ist, behandelt ein im Umgang mit informationstechnischen Systemen in der Verwaltung oft befürchtetes Problem: Die Figur der Carol Beer (gespielt von David Walliams) ist in verschiedenen Situationen etwa als Rezeptionistin eines Krankenhauses oder als Bankangestellte mit einfachen Organisationsfragen konfrontiert. So soll sie etwa einen Kredit bewilligen oder ein Zimmer im Krankenhaus für die Entbindung einer Schwangeren zuweisen. Carol folgt dabei stets demselben Muster: Sie tippt einige Daten in ihren Computer ein, schaut die „Kunden" nachdrücklich an, und sagt bedauernd: „Computer says No" – Der Computer sagt Nein. Auf die Nachfrage, warum oder weshalb dieses Ausgabeergebnis erfolgt, wiederholt sie gebetsmühlenartig ihre Phrase. Aus der sich steigernden Ungeduld und Panik der Bittsteller, auf die Carol mit stoischer Ruhe reagiert, entwickelt sich eine besondere Komik der Situation.

Diese Formen kabarettistischer Bilder erzeugen ihre Kraft daraus, dass sie Wirklichkeiten womöglich überzeichnen, aber dennoch im Kern wahre Befürchtungen ansprechen. Wer eine Möglichkeit der Entscheidungsfindung durch informationstechnische Systeme zur Verfügung hat, neigt womöglich dazu, Grundregeln des menschlichen Miteinanders und des common sense zu missachten. Darüber hinaus kann sich für beide Seiten das Problem ergeben, dass das Ausgabeergebnis nicht in Frage gestellt wird, und auch nicht in Frage gestellt werden kann, da es an kompetenten Erklärungsmöglichkeiten fehlt, warum und wie der Computer zu einem bestimmten Ausgabeergebnis gelangt ist. Die Frage, die sich also aus dem überzeichneten Bild aus Little Britain ergibt, mag durchaus auf aktuelle Prozesse der Reorganisation des Verwaltungsverfahrens ausstrahlen. Kann sich in der Digitalisierung der Verwaltung ein ähnliches Bild ergeben, dass der Bürger mit undurchsichtigen Algorithmen konfrontiert und mit mangelnden Erklärungskompetenzen abgespeist wird?

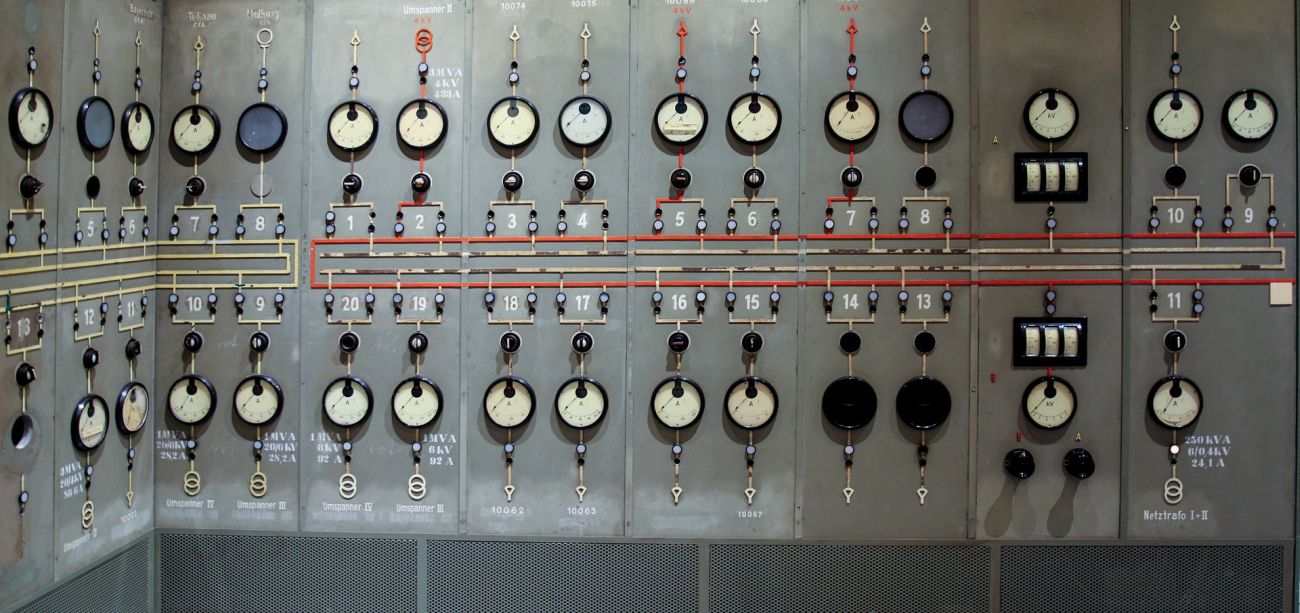

Grundsätzlich ergibt sich natürlich das Problem der Transparenz und Kontrolle, wenn Verwaltungsentscheidungen durch maschinelle Verfahren erfolgen. Im Steuer- und im Sozialrecht wurden schon weitreichende Möglichkeiten der Vollautomatisierung durch den Gesetzgeber eingefügt. Insbesondere wenn auf der technischen Seite Methoden des maschinellen Lernens zur Automatisierung verwendet werden (was gegenwärtig nur sehr restriktiv erfolgt), kann es unter Umständen auch tatsächlich herausfordernd sein, das Ausgabeergebnis einer Datenverarbeitung nachvollziehen zu können. Die mangelnde Erklärbarkeit von Entscheidungen kann unter Umständen auch eine verringerte Akzeptanz zur Folge haben.

Das auf das deutsche Verwaltungsverfahren anwendbare Recht regelt Begründungs- und Rechtfertigungserfordernisse für Verwaltungsentscheidungen zunächst einmal allgemein. § 39 des Verwaltungsverfahrensgesetzes (eine Entsprechung des Wortlauts findet sich auch in den Landesverwaltungsverfahrensgesetzen) sieht eine Begründungspflicht für Entscheidungen der Verwaltung vor. Nach der Rechtsprechung des Bundesverwaltungsgerichts hat „der Staatsbürger, in deren Rechte die Verwaltung eingreift, einen Anspruch darauf [...], die dafür maßgeblichen Gründe zu erfahren, weil er nur dann in der Lage ist, seine Rechte sachgemäß zu verteidigen." Weitere Erklärungsrechte, deren Reichweite im Einzelnen äußerst umstritten ist, können aus der Datenschutzgrundverordnung der EU abgeleitet werden. Hier wird unter dem Stichwort eines „Rechtes auf Erläuterung" diskutiert, inwieweit Verwender automatisierter Entscheidungssysteme für Betroffene eine Erklärung bereithalten müssen und welche Elemente diese im Einzelnen umfasst. Diskutiert wird etwa darüber, ob Verwender die zugrundeliegenden Algorithmen oder die Trainingsdaten von neuronalen Netzwerken offenlegen müssen.

Ganz allgemein ist unter dem Begriff der Begründung fraglich, was überhaupt für den betroffenen Bürger zu einer „Erklärung" einer algorithmischen Entscheidung beiträgt. Zunächst einmal dient die Begründung der internen Nachprüfbarkeit der Entscheidung in der Verwaltung selbst, der sogenannten Selbstkontrolle. Weitergehend erlaubt sie die externe Nachprüfung durch Gerichte, die Fremdkontrolle. Dies ist aber noch nicht alles. Denn durch die Begründung in einer für den Menschen verständlichen Form kommt auch die Anerkennung des Bürgers als Subjekt, dem der Staat für Eingriffe Gründe „schuldet" zur Geltung. Alle diese Funktionen gemeinsam führen zur Anerkennung des Verwaltungsverfahrens als einem legitimen Prozess zum Ausgleich wechselseitiger Interessen.

Es ist offensichtlich, dass diese komplexen Ziele nicht einfach mit einer Offenlegung des Algorithmus oder der Sachverhaltsdaten erreicht werden können. Auch die grundsätzlich wünschenswerte Vision einer „erklärbaren KI," in die eine Erklärungsfunktion der eigenen Entscheidungen eingebaut ist, steckt noch in den Kinderschuhen und begegnet insbesondere bei komplexen statistischen Fällen besonderen technischen Schwierigkeiten.

Dabei wird oft übersehen, dass es auf eine kausale Begründung von Entscheidungen im Recht meist gar nicht ankommt. Die Tradition der Begründung von Verwaltungsentscheidungen wurzelt viel tiefer in der Idee einer Einbettung in eine Serie von Überprüfungen durch Vorgesetzte und Gerichte, als dass sie sinnvoll durch maschinelle Verfahren erledigt werden kann. Dies gilt insbesondere im Hinblick darauf, dass der menschliche Organwalter in der Verwaltung auch eine Art „black box" darstellt, dessen innere Ausrichtung dem Bürger notwendigerweise verborgen bleibt. Der menschliche Entscheidungsträger in der Verwaltung kann „seinen Algorithmus" auch nicht einfach so offenlegen, entscheidende Elemente seines Entschlusses werden dem Bürger verborgen bleiben und sind als solche auch nicht gerichtlich nachprüfbar. Der Bürger hat also meist keine Möglichkeit, die „wahren" Gründe für eine Verwaltungsentscheidung zu erfahren. Das Recht begnügt sich hier mit einer nachträglichen Rechtfertigbarkeit einer Entscheidung, die den Maßstab für die verwaltungsgerichtliche Kontrolle bietet.

Gegenwärtig besteht daher weitestgehend Unklarheit, wie genau die Begründung von automatisierten Entscheidungen aussehen kann. Dabei liegt das Problem tiefer als nur eine „Erklärung" für algorithmische Prozesse zu liefern. Die Rechtspraxis in der Verwaltung ist ein komplexer Prozess menschlicher Interaktion, der sich nur schwer auf Rechenmodelle reduzieren lässt. Gleichzeitig soll und muss auch der Staat das Potential der digitalen Transformation ausschöpfen. Im besten Falle werden auch in der öffentlichen Verwaltung Ressourcen für bürgerfreundlichere Verfahren freigesetzt.

Soll dieser Prozess gelingen, muss man sich jedoch der spezifischen Unterschiede menschlichen und maschinellen Entscheidens gewahr werden. Das bedeutet in der Verwaltungspraxis insbesondere, dass algorithmische Verfahren nicht einfach menschliche Entscheidungsprozesse ersetzen können. Um die aus der Digitalisierung folgenden Effizienz- und Effektivitätsgewinne für den Menschen nutzbar machen zu können, müssen wir unsere Verfahren in einer Weise neugestalten, um sowohl Mensch und Maschine gerecht werden zu können.

Für unser Bedürfnis für eine maschinelle Entscheidung eine Erklärung zu erhalten, kann dies bedeuten, anzuerkennen, dass es aufgrund der unterschiedlichen Funktionsweise menschlicher und maschineller Entscheidungen, Situationen geben kann, in denen wir für ein Ausgabeergebnis tatsächlich keine Erklärung finden können. Entscheiden wir uns als politische Gemeinschaft für die Digitalisierung unserer öffentlichen Verwaltung, so muss das grundsätzliche Risiko der Verwendung von Algorithmen im Verwaltungsverfahren durch alternative Verfahrensrechte der Betroffenen kompensiert werden. Denkbar wäre es etwa Beweislastregelungen zugunsten des Bürgers anzupassen oder das Widerspruchverfahren zu reformieren. Transformative Prozesse wie die Digitalisierung zeichnen sich dadurch aus, dass sie gegenwärtige Strukturen radikal in Frage stellen und dabei die Chance bieten, sich mit innovativer Neugestaltung auf (demokratische) Grundprinzipien der Staatsorganisation zurückzubesinnen. Für ein solches kreatives Möglichkeitsdenken bieten mittlerweile einige Institutionen in Deutschland ein fruchtbares Forum.

Veröffentlicht: 08.01.2020