Messtechnisch erhobene Daten – über jeden Zweifel erhaben?

Messtechnisch erhobene Daten – über jeden Zweifel erhaben?

von Gabriele Goldacker

Von technischen Geräten gemessene und in technischen Systemen gespeicherte Daten mögen vielen als das Maß aller Dinge erscheinen: unvoreingenommen, genau und vertrauenswürdig. Doch können Daten derartige Erwartungen überhaupt erfüllen? Nicht erst bei der Interpretation, auch bereits bei der Erfassung und Aufbereitung solcher Daten ergeben sich Risiken hinsichtlich einer Verzerrung der Abbildung.

Dieser Beitrag möchte für die »natürlichen« Grenzen des Messens und der scheinbar neutralen Aufbereitung gemessener Daten sensibilisieren. Er beschreibt schlaglichtartig, weshalb auch messtechnisch erhobene Daten keine 1-zu-1-Abbildung der Realität sind, und gibt Hinweise, wie mit den Daten umgegangen werden sollte, um verschiedenen Quellen von Ungenauigkeiten entgegenzuwirken.

Kein Messdatum, nicht einmal ein einzelnes, unmittelbar am Messgerät erfasstes Messergebnis, ist ein absolut genaues Abbild des Gemessenen. Selbst wenn ein Messwert für die beabsichtigte Nutzung ausreichend genau ist, können für die angemessene Interpretierbarkeit des Wertes Begleitdaten (»Metadaten«) erforderlich sein, die ebenfalls erfasst werden und bestimmte Anforderungen erfüllen müssen.

Vielfach kann auch nicht alles von Interesse bis in alle Einzelheiten gemessen werden, deshalb werden z. B. zeitliche, räumliche oder mengenmäßige Stichproben genommen. Aus Messwertmengen werden »Mittelwerte« oder »Normalwerte« gebildet oder es wird z. B. auf andere Zeitpunkte oder Orte »geschlossen«. Verbreitet ist auch die erneute Nutzung von Messwerten für einen gänzlich anderen als den ursprünglichen Erhebungszweck.

Im Folgenden wird dargestellt, welches »gesunde Misstrauen« im Umgang mit (ursprünglich) messtechnisch erhobenen Daten angebracht ist.

1 Rohdatengewinnung

Oft wird von sogenannten »Roh«daten gesprochen, wenn von unmittelbaren Messwerten die Rede ist, also von mit Messgeräten bestimmten Daten. In den Köpfen vieler Menschen existiert dabei zudem noch das klassische Bild eines idealen Messgerätes, das ein ganz bestimmtes Phänomen der realen Welt beobachtet und eins zu eins abbildet. Diesen Rohdaten wird eine besonders große Authentizität zugesprochen.

1.1 Einfluss des Messgerätes

In dem Moment, in dem wir einen Messwert erhalten, hat dieser bereits vielen Einflussfaktoren unterlegen, insbesondere der Genauigkeit und der Auflösung des Messgerätes.

Unter der Genauigkeit eines Messgerätes wird im allgemeinen Sprachgebrauch die Toleranz verstanden, mit der eine Messung vom tatsächlichen Wert abweichen kann bzw. darf. Die Genauigkeit wird üblicherweise als Prozentsatz bezogen auf einen Referenzwert (z. B. den Maximalwert der Messgeräteskala, wenn diese bei »0« beginnt) oder als absolute zulässige Abweichung angegeben. Bei vielen Messgeräten im alltäglichen Gebrauch wird man Genauigkeitsangaben jedoch vergeblich suchen: Dies gilt für Messbecher in der Küche und Alkoholtester für den Privatgebrauch, vor allem aber bei Geräten, bei denen bestimmte Funktionen nur »nebenbei« zum Messen benutzt werden – z. B. die Funk-Datenübertragung von Smartphones zur Messung von Entfernungen. Die Messgenauigkeit kann beispielsweise durch das Messverfahren selbst oder durch das Produktions- und Prüfverfahren für das Messgerät bestimmt sein. Innerhalb des Messgenauigkeitsspielraumes können sowohl alle Messwerte einen einheitlichen Versatz gegenüber den jeweiligen realen Werten besitzen (»Richtigkeit«) als auch die einzelnen Messwerte unterschiedlich stark vom tatsächlichen Wert abweichen (»Präzision«). Bei einer einzelnen Messung können sich beide Effekte addieren oder bestenfalls auch gegenseitig eliminieren.

Die Auflösung eines Messgerätes in einer Dimension (z. B. räumliche Entfernung oder Zeit) beschreibt, wie weit zwei zu messende Werte voneinander verschieden sein müssen, damit das Gerät zwischen den Werten unterscheiden kann.

Die Genauigkeit und die Auflösung eines Messgerätes sind in der Regel Folgen wirtschaftlicher Entscheidungen: Der Hersteller stellt genau die Qualitätsmerkmale zur Verfügung, die seine Zielkunden benötigen. Nutzer:innen beschaffen nicht beliebig hochwertige Geräte, sondern solche, die ihre Anforderungen erfüllen – und machen dabei ggf. noch Abstriche, wenn das Budget nicht reicht.

Genauigkeit und Auflösung können prinzipiell in beliebiger Kombination vorkommen, manche Kombinationen führen jedoch zu Messwerten, die nicht auf Anhieb korrekt interpretierbar sind:

Beispielsweise kann ein Messwert »7,4« (bei beliebiger Einheit) – oberflächlich betrachtet – suggerieren, dass der tatsächliche Wert zwischen 7,35 und 7,449 liegt und allenfalls die aus der Schule bekannten kaufmännischen Rundungsregeln angewendet wurden. Bei einer Genauigkeitstoleranz von mehr als +/- 0,049 absolut ist diese Annahme jedoch nicht mehr berechtigt.

Bei einem genaueren und höher auflösenden Messgerät hingegen kann derselbe Messwert »7,4« bedeuten, dass der tatsächliche Wert zwischen 7,395 und 7,4049 und damit in einem weitaus kleineren Intervall liegt.

Im Zusammenhang mit der Auflösung steht auch die Abtastrate eines Gerätes, das Messwerte in gleichmäßigen Zeitabständen oder -intervallen erfasst.

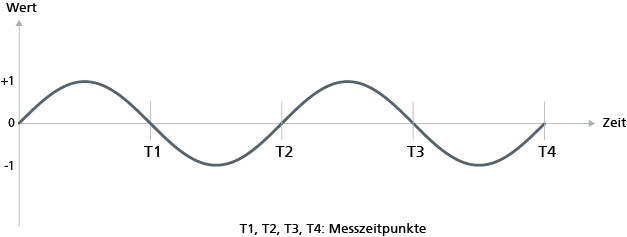

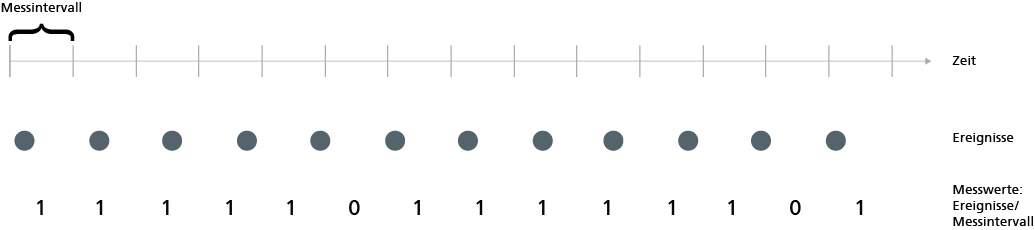

Bei ungünstiger Abtastrate können Effekte entstehen, die zu einer Fehlinterpretation der Daten führen können. So zeigt z. B. die obige erste Abbildung eine Abfolge von Ereignissen, bei der jedes Ereignis in absolut gleichem zeitlichem Abstand zum vorangehenden Ereignis auftritt. Die pro gezeigtem Zeitintervall aufgezeichneten Daten lassen dies jedoch nicht mehr auf Anhieb erkennen. Die zweite Abbildung zeigt die bekannte Sinuskurve. Tastet man diese (zufällig) stets genau dann ab, wenn die Kurve die Nulllinie schneidet, kann der Eindruck entstehen, es herrsche dauerhaft der Nullzustand. Ist der zeitliche Abstand der Ereignisse nicht von vornherein bekannt, kann auch ein prinzipiell dafür geeignetes Messgerät nicht entsprechend vorkonfiguriert werden und die Messwerte sollten im Nachhinein ggf. auf derartige Effekte hin überprüft werden.

Genauigkeit, Auflösung, Abtastrate und weitere dauerhafte Eigenschaften des Messgerätes gehören zu den Metadaten einer Messung.

Ein ganz anderer Einfluss des Messgerätes ist der auf die gemessene Situation selbst. Solche Effekte sind aus der Teilchenphysik bekannt, begegnen uns aber auch im täglichen Leben: Nicht wenige Autofahrende verringern ihre Geschwindigkeit, wenn sie wissen, dass sie gleich an einem Blitzer vorbeifahren werden.

1.2 Mit besonderer Vorsicht zu genießen: Mittelbar gewonnene Messdaten

Entfernungen misst man mit Lineal, Maßband, Messrad – oder? Und wenn die Messung in der Natur mit solchen Werkzeugen zu aufwändig oder unmöglich ist? Dann behilft man sich häufig mit einer Messung auf einer »maßstabsgetreuen« Karte. Allerdings besitzt jede plane Karte eine Verzerrung gegenüber der gewölbten Erdoberfläche, die sich durch ein noch so genaues Messgerät allein nicht ausgleichen lässt. Ebenfalls in die Kategorie mittelbar gewonnener Messdaten fällt die Entfernungsmessung mittels Funk. Ebenso wie die Lautstärke mit zunehmender Entfernung von der Schallquelle systematisch abnimmt, gilt dies auch für die Stärke von Funksignalen. Kennt man also die Stärke des ursprünglichen Signals, kann man Aussagen über die Entfernung zwischen Signalquelle und Empfänger machen. Allerdings muss man bei Funk – wie vom Schall bekannt – berücksichtigen, dass etwaige dämpfende Objekte auf dieser Strecke den Anschein größerer Entfernung hervorrufen.

Ein weiteres Beispiel sind GPS-Positionsbestimmungen. GPS-Positionsbestimmungen kombinieren die beobachteten Laufzeiten mehrerer Satellitensignale. Abhängig von der Tageszeit, dem Wetter und beweglichen Objekten zwischen Messgerät und Satellit sind für ein Messgerät unterschiedliche Satelliten »sichtbar«, Satellitenbahnen sind nicht absolut stabil – daraus ergeben sich Messunterschiede zwischen Messungen am selben Ort, bzw. die Messung an verschiedenen Orten (im Ungenauigkeitsbereich) kann denselben Wert ergeben.

2 Situationsbeschreibende Begleit- bzw. Metadaten

Häufig wird nicht nur genau ein konkret interessierender Wert gemessen, sondern gleichzeitig werden weitere, situationsbeschreibende Metadaten erfasst, z. B. der Messzeitpunkt oder klimatische Umgebungsbedingungen.

Nur bei in jeglicher Hinsicht sehr konstanten realen Zuständen – wie der Höhe eines (nicht-vulkanischen) Berges – kann für den landläufigen Gebrauch (z. B. in Lexika oder sogar Bergsteigerkarten) auf solche Metadaten verzichtet werden.

In vielen Szenarien sind jedoch diese situationsbeschreibenden Metadaten für die korrekte Interpretation des Messwertes erforderlich und müssen daher ebenfalls bestimmte Genauigkeits- und Auflösungsanforderungen erfüllen. (Zumindest) in solchen Fällen sollten auch bei der Präsentation von Messergebnissen und bei deren Weitergabe die relevanten Metadaten mitgeliefert werden, damit sich die Empfänger ein eigenes Bild über die Validität der Daten für den jeweiligen Zweck machen können. Wer selbst Messdaten auswertet, sollte sich stets fragen, ob ihm alle erforderlichen Metadaten vorliegen und wie diese bei der Auswertung berücksichtigt werden müssen.

Ein typisches Beispiel für die Wichtigkeit situationsbeschreibender Metadaten sind (automatische) Zählungen, z. B. an Autobahnmessstellen, die – für sich genommen – meist nur eine grobe Interpretation erlauben und sogar fehlinterpretiert werden können, wenn man beispielsweise Zahlen, die an einem Feiertag (üblich: wenige Fahrzeuge pro Zeiteinheit) gemessen wurden, auf die Hauptberufszeit (üblich: viele Fahrzeuge pro Zeiteinheit) verallgemeinert. Ein weiteres Beispiel sind Schadstoffmessungen an Straßenkreuzungen. Derartige Messungen hängen nicht nur von zeitlichen, sondern auch von vielfältigen klimatischen Bedingungen – wie Windrichtung und -stärke, Temperatur … – ab, und können sogar von gesellschaftlichen Ereignissen (wie Staus durch ein anstehendes Fußballspiel) beeinflusst werden.

3 Das Internet der Dinge: Schlaraffenland messtechnisch gewonnener Daten?

Gerade im Zusammenhang mit dem Internet der Dinge (Internet of Things, IoT) wird uns oft mit Verweis auf die Ubiquität von Messgeräten eine Demokratisierung und Demonopolisierung von z. B. Umweltdaten in Aussicht gestellt. Dies kann zutreffen, wenn Organisationen mit ausreichendem Verständnis für die von ihnen gemessenen Daten qualitativ angemessene (z. B. geeichte) Messgeräte einsetzen und die für die jeweilige Interpretation der Daten erforderlichen Metadaten mitliefern.

Mit der Vielzahl der von einfachen Messgeräten – z. B in Smartphones oder Fitnesstrackern – aufgezeichneten Daten sollten ebenfalls stets alle relevanten Metadaten (zumindest hinsichtlich des verwendeten Gerätetyps) mitgeliefert werden, damit die Datennutzer:innen sich ein qualifiziertes Bild der Datengenauigkeit und der Eignung der Daten für die beabsichtigten Einsatzzwecke machen können. Die Messdaten solcher Geräte sollten nur unter besonders sorgfältiger Berücksichtigung der dokumentierten oder zu erwartenden Genauigkeit von Daten und Metadaten genutzt werden. Derartige Messdaten können in vielen Alltagssituationen nützlich sein – wo es vielleicht nicht auf ein Zehntelgrad Celsius ankommt –, sie stoßen aber schnell an ihre Grenzen, wenn es z. B. um eine rechtliche Belastbarkeit der Daten geht.

4 Messreihen und Stichprobenmessungen

Häufig wird ein kontinuierliches, veränderliches Phänomen nicht dauerhaft bzw. ein diskretes, veränderliches Phänomen nicht bei jedem Auftreten beobachtet – sei es aufgrund eingeschränkter Beobachtungs- oder begrenzter Aufzeichnungsmöglichkeit.

Messreihen erfassen über einen gewissen Zeitraum z. B. ein Phänomen, die Situation an einem bestimmten Ort oder die Situation zu einer bestimmten Tageszeit. Ebenso kann sich eine Messreihe auf ein und denselben Zeitpunkt beziehen, aber mittels unterschiedlicher Messgeräte gleichzeitig erstellt werden. Eine weitere Variante ist, ein bestimmtes Phänomen bei verschiedenen Objekten zu messen.

Messreihen können verschiedene Zwecke verfolgen, z. B. nach Periodizitäten eines Phänomens zu suchen, »Normalwerte« eines Phänomens zu bestimmen oder »mittlere« Eigenschaften eines Phänomens herauszufinden. Auch für die Verbesserung des Messergebnisses werden Messreihen benutzt, nämlich wenn veränderliche geräteexterne Einflüsse (wie bei den indirekten Messungen beschrieben) das Messergebnis beeinträchtigen können.

Bevor Messreihen durchgeführt werden, sollte man sich (soweit möglich) klarmachen, welche Faktoren das Phänomen beeinflussen und die Messungen so gestalten, dass alle Faktoren dabei angemessen berücksichtigt werden. Zu derartigen Faktoren können z. B die Tageszeit oder klimatische Zustände in der Nähe des Phänomens, aber auch gesellschaftliche Faktoren (wie kollektive Ruhetage) gehören. Man muss sich jedoch im Klaren sein, dass immer eine Restunsicherheit bliebt, wesentliche Faktoren übersehen und damit unberücksichtigt gelassen zu haben. Dies kann zu Fehlern bzw. Ungenauigkeiten bei den Ergebnissen führen, wenn die Messergebnisse weiterverarbeitet werden.

Neben Messreihen sowie zur »Ausdünnung« von Messreihen kommen auch Stichproben zum Einsatz. Prinzipiell ist jede Einzelmessung eine Stichprobenmessung, da sie sich stets auf einen bestimmten Zeitpunkt und die zu diesem Zeitpunkt herrschenden Messbedingungen bezieht. Bei gezielter Stichprobennahme werden (zumindest bezüglich einiger Einflussfaktoren) zufällige Messungen vorgenommen bzw. Messwerte aus einer Messreihe zufällig ausgewählt, in der Hoffnung, ein repräsentatives Messergebnis zu erhalten. Bei der Auswertung von Stichprobenmessungen sollten die möglichen Abweichungen von der Realität im Auge behalten werden, bei der Präsentation entsprechender Ergebnisse sollte man den Stichprobenumfang und weitere relevante Metadaten (z. B. den Zeitraum, aus dem die Stichprobendaten stammen) nennen.

5 Reduzieren von Datenmengen auf einen »zentralen« Wert

Insbesondere wenn größere Messwertreihen oder Stichproben erfasst wurden, werden in der Regel nicht die Rohdaten eins zu eins präsentiert, sondern auf einzelne Werte kondensiert.

Oft geht es darum, geräteexternen Einflüssen auf die Messungen zu begegnen bzw. »erwartbare« Eigenschaften eines Phänomens herauszufinden. Das Problem stellt sich bei der Wahl des am besten geeigneten Verfahrens, da nicht (oder zumindest nicht von vornherein) unbedingt bekannt ist, welches Verfahren sich für den konkreten Fall besonders gut bzw. schlecht eignet. Es kommt allerdings auch vor, dass gezielt nur die Ergebnisse jenes Verfahrens präsentiert werden, die den eigenen Interessen besonders zugutekommen.

Handelt es sich um numerische Messwerte, kommen dafür vor allem drei Verfahrensgruppen infrage, die Bestimmung des arithmetischen Mittels (»Durchschnitt«), die Ermittlung des Medians und die Ermittlung des Modus.

Bei der (ungewichteten) Bestimmung des arithmetischen Mittels werden alle verfügbaren Werte aufaddiert und das Ergebnis durch die Anzahl der Messwerte geteilt.

Der Median (Zentralwert) einer Menge von Messwerten wird ermittelt, indem alle Messwerte auf- bzw. absteigend sortiert und anschließend der mittlere Wert der entstehenden Reihe (bzw. die Mitte zwischen den beiden mittleren Werten) benutzt wird.

Aber sowohl Mittelwert als auch Median sind nicht unbedingt »repräsentativ« im Hinblick auf eine intuitive Interpretation der Rohdaten – bei Datenmengen mit mehreren Wertehäufungen beispielsweise können gerade Mittelwert und Median »besonders uninteressant« sein.

In manchen Messwertemengen ragt, mit Ausreißern nach oben und unten, ein bestimmter Wert heraus. Der Modus einer solchen Messwertemenge ist der Wert, der am häufigsten gemessen wurde. Offensichtlich ist jedoch, dass es nicht für jede Messwertemenge genau einen Modus gibt. Der Modus allein eignet sich deshalb nicht für eine automatische, messgeräteinterne Datenreduktion.

Schon zur angemessenen Bestimmung der zentralen Tendenz ist also eine Berücksichtigung der Verteilung der Messwerte unerlässlich. Auf eine solche Darstellung wird jedoch oft verzichtet, da sonst der Vorteil der starken Kondensation der Daten verloren geht. Entsprechend bietet bereits die Ausweisung eines zentralen Wertes beträchtliche Möglichkeiten, die mit den Daten verbundene Aussage zu beeinflussen.

Wurde stets dasselbe Messgerät benutzt, ist zudem zu beachten, dass alle berechneten zentralen Werte mit der Richtigkeitsabweichung des Messgerätes behaftet sind!

6 »Schlussfolgern« von Werten

Speziell bei Wetterdaten fällt es selbst dem interessierten Laien auf, dass wir von manchen Anbietern Daten selbst für die kleinste Gemeinde erhalten – auch wenn sich dort keine Messstelle befindet. In diesen Fällen wurden die angegebenen Werte nicht gemessen, sondern durch Schlussfolgern gewonnen (z. B. ein geeignet erscheinender zentraler Wert über die Messwerte umliegender Messstellen). Einige Anbieter kennzeichnen dies, beispielsweise durch Angabe der Entfernung zur nächsten Messstelle, – andere hingegen nicht.

7 Umnutzung von Messwerten

In vielen Fällen wird auf Messwerte zurückgegriffen, die bereits in anderem Kontext erfasst wurden. Besonders aus Kostengründen scheint sich oft ein derartiges Vorgehen anzubieten. Ein einfaches Beispiel: Ein öffentlicher Sport- und Bolzplatz wird mit Bewegungsmeldern überwacht, um bei unzulässiger Nutzung (z. B. in Ruhezeiten) schnell einschreiten zu können. Das qualitative Messergebnis lautet also jeweils: »Nutzer anwesend« oder »keine Nutzer anwesend«. Nun könnte man auf die Idee kommen, die Nutzungsintensität allein aufgrund dieser – weil sowieso verfügbaren – Messwerte bestimmen zu wollen. Dies kann allenfalls gelingen, wenn eine zur Natur der Messdaten passende Interpretation des Begriffes »Nutzungsintensität« zugrunde gelegt und bei der Präsentation von Ergebnissen auch kommuniziert wird: Auf einer solchen Datenbasis könnte die Nutzungsintensität als »Stunden pro Tag« definiert werden, nicht jedoch– obwohl intuitiv näher liegend – als »Summe der Nutzungsdauer jedes einzelnen Nutzers pro Tag«.

Im Zusammenhang mit der aktuellen Diskussion um Open Data werden vor allem die mit einer Nachnutzung vorhandener Daten verbundenen Möglichkeiten z. B. für Wirtschaft und Verwaltung oder für Umweltschutz, Nachhaltigkeit und Smart Cities herausgestellt. Aber gerade, wenn Daten über Plattformen einem offenen Nutzerkreis für einen vorab unbekannten Nutzungszweck zur Verfügung gestellt werden, ist auf beiden Seiten große Sorgfalt erforderlich: Die Bereitsteller sollten möglichst umfangreiche Metadaten mitliefern und die Nutzer müssen prüfen, ob die Daten in Kombination mit den verfügbaren Metadaten tatsächlich für ihre Zwecke geeignet und ausreichend sind.

8 Fazit

Auch wenn messtechnisch erhobene Daten selbst frei von Einflüssen sind, die sich bei Befragungen durch die soziale Interaktion zwischen befragender und befragter Seite ergeben, sind die Möglichkeiten, die reale Welt mit derartigen Daten korrekt zu beschreiben, trotzdem begrenzt: Das liegt an der (mehr oder weniger großen) Unvollkommenheit der Messtechnik und beschränkten (z. B. zeitlichen) Ressourcen, aber auch am tatsächlichen Informationsgehalt der Daten. Verantwortungsbewusste Nutzer der Daten müssen also immer wieder prüfen, ob ihre Ergebnisse frei von unberechtigten eigenen Interpretationen sind, und bei der Präsentation von Ergebnissen deutlich zwischen datenbasierten Ergebnissen und darauf aufbauenden Interpretationen unterscheiden. Schon einfachste statistische Operationen können, wie etwa bei der Ausweisung einer zentralen Tendenz, stark interpretierend sein.

Entsprechende Vorsicht ist bei der Rezeption von Datenauswertungen geboten. Wem anscheinend Rohdaten präsentiert werden, der sollte hinterfragen, ob die Datenbasis diese überhaupt hergibt, wem abgeleitete Ergebnisse präsentiert werden, der sollte kritisch beurteilen, ob diese tatsächlich direkt aus den Rohdaten gewonnen werden können und welche Aussagekraft sie im konkreten Fall besitzen.

Veröffentlicht: 29.07.2020