Wie »Explainable AI« KI-Algorithmen nachvollziehbar macht

Blick in die »Black Box«: Wie »Explainable AI« KI-Algorithmen nachvollziehbarer macht

von Marc Hanussek

KI-Verfahren, insbesondere maschinelle Lernverfahren, laufen in immer mehr Branchen und Aufgaben menschlichen Entscheider:innen den Rang ab. Sie klassifizieren Luftbilder, fassen Nachrichtentexte zusammen oder prognostizieren den Gasverbrauch – oft genauer und immens schneller als wir Menschen das können.

Intransparente Entscheidungen

Doch so erstrebenswert der KI-Einsatz vielerorts auch ist - es gibt auch Schattenseiten. Ein Nachteil, den viele Lernverfahren teilen, ist die mangelhafte Nachvollziehbarkeit, Erklärbarkeit oder Transparenz von Entscheidungen, die solch hochkomplexe Modelle treffen. Vor allem in Situationen, in denen Menschen akut betroffen sind – etwa in der Hautkrebserkennung im Gesundheitswesen oder bei der Personalauswahl in öffentlichen Einrichtungen – wird neben hoher Genauigkeit des Modells auch die Nachvollziehbarkeit des Ergebnisses relevant. So kann die Entscheidung im Zweifelsfall, zum Beispiel aufgrund rechtlicher Auskunftspflichten, von einem Experten validiert werden.

Explainable AI: Vom Forschungsfeld in die Praxis

Das Teilgebiet »Explainable AI« (XAI) des maschinellen Lernens befasst sich mit Methoden und Verfahren, die einen solchen Blick in die Black Box der KI-Verfahren ermöglichen sollen. Dabei befindet es sich derzeit in der spannenden Übergangsphase vom reinen Forschungsfeld zur unternehmerischen Praxis. Neben komplexen mathematischen Verfahren und deren Implementierungen gibt es in letzter Zeit auch massentaugliche Demonstratoren, die das Thema Fachfremden näherbringen soll.

VitrAI: Demonstrator für erklärbare KI

Einen solchen Demonstrator hat das Fraunhofer IAO in Zusammenarbeit mit der Universität Stuttgart gebaut. VitrAI, ein Kompositum aus vitrum (lateinisch für Glas als Sinnbild für die »Glass Box«) und AI (»artificial intelligence«, englisch für künstliche Intelligenz), demonstriert anhand drei praxisnaher Anwendungsfälle verschiedene XAI-Verfahren:

- Beschwerden über den öffentlichen Nahverkehr werden in Klassen wie zum Beispiel »Fahrt unpünktlich« eingeteilt

- Autobilder werden nach der Kfz-Marke klassifiziert

- Auf Basis tabellarischer Daten wie etwa der Luftfeuchtigkeit oder des Luftdrucks soll Niederschlag prognostiziert werden

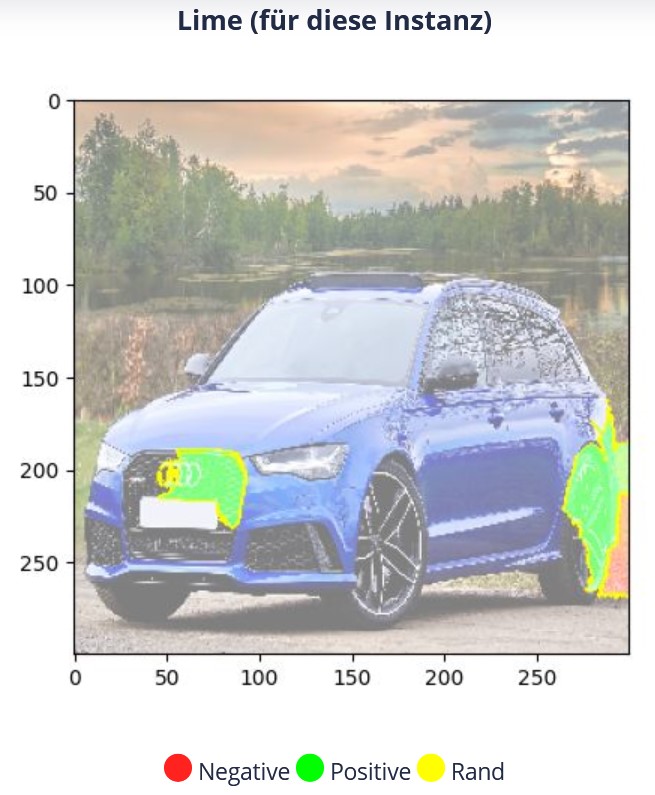

In jedem dieser Anwendungsfälle können Anwender:innen ein Beispiel auswählen und sich die vom hinterlegten KI-Modell getroffene Entscheidung erklären lassen. Dies kann im Falle von Automarken und dem genutzten XAI-Verfahren LIME etwa so aussehen:

In Rot, rechts unten im Bild, sind solche Bildbereiche eingefärbt, die aus Sicht des KI-Modells gegen die Entscheidung »Audi« sprechen. Im Gegensatz dazu sind Bereiche grün, die als pro »Audi« anzusehen sind. Teile des Kühlergrills und des Markenlogos scheinen also für die Klassifikation als Audi relevant gewesen zu sein. Dasselbe gilt für die Hinterradfelge.

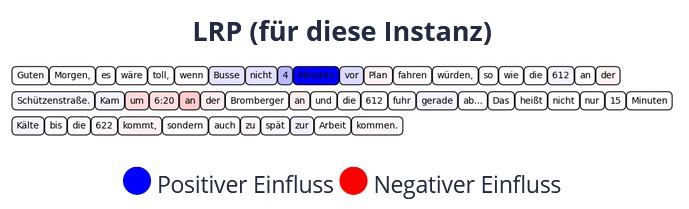

Im Falle der Nahverkehrsbeschwerden und Nutzung des LRP-Verfahrens sieht das Ganze wie folgt aus (Erklärung für Entscheidung »Fahrt unpünktlich«):

Wie man sieht, waren für das KI-Modell vor allem Worte wie »Minuten«, aber auch »4« oder »vor« Indikatoren für eine unpünktliche Fahrt.

Während Anwender:innen nur die oberste Schicht, also die bildlichen Erklärungen, sehen, sind unter der Haube zwei weitere Schichten verborgen, die für die anschließenden Erklärungen relevant sind. Die unterste Schicht ist die Datenschicht, die aufgrund ihrer Beschaffenheit (z.B. Verteilung der Daten über die Klassen oder die Varianz der Daten) das Training und das ML-Modell beeinflusst. Dies ist dann auch die zweite Schicht: Erklärungen beziehen sich immer auf ein konkret gewähltes ML-Modell, in diesem Fall wurden neuronale Netze verwendet. Würde man ein anderes Modell heranziehen, würden die Erklärungen höchstwahrscheinlich anders aussehen. Die drei vorgestellten Anwendungen, also Bild- und Textklassifikation sowie die Klassifikation tabellarischer Daten, entsprechen den Hauptanwendungsgebieten von XAI. Aber auch in Regressionsaufgaben, also der zahlenmäßigen Prognose von Werten, kann XAI Anwendung finden.

XAI ist hilfreich, aber kein Wundermittel

Bei näherem Hinsehen wird deutlich, dass XAI in der Tat in der Lage dazu ist, Entscheidungen von KI-Modellen nachvollziehbar zu machen. Vieles von dem, was die einzelnen Verfahren als positiv oder negativ hervorheben, können wir Menschen nachvollziehen. Anderes hingegen weniger – warum sind beim Audi-Bild etwa Teile des Hintergrunds rot eingefärbt? Oder warum ist im Textbeispiel »4« blau und »15« nicht? Sollten nicht beide Zahlen das Modell entweder in die eine oder andere Richtung beeinflussen? Ob solche Phänomene nun an den Daten selbst, dem KI-Modell oder dem XAI-Verfahren liegen, ist im Allgemeinen nur schwer zu erkennen. Manchmal sind sich verschiedene XAI-Verfahren auch nicht einig, im schlimmsten Fall stiftet XAI also mehr Verwirrung als Aufklärung.

Auch Ethik und Vertrauen in KI sind Ziele von XAI

Bevor XAI also ähnlich breit wie KI-Verfahren selbst eingesetzt werden kann, braucht es noch ein bisschen. Neben der reinen Nachvollziehbarkeit von Entscheidungen kann mit XAI aber auch die Einhaltung ethischer Prinzipien beim KI-Einsatz überprüft werden. So wollte Amazon Bewerbungen mittels KI vorsortieren. Als sich herausstellte, dass der Algorithmus systematisch Frauen benachteiligte, wurde das Projekt begraben. Will zum Beispiel der Staat zwar einerseits von der Power der KI profitieren, andererseits aber ethische Standards sicherstellen, kann ihn XAI dabei unterstützen. Im Falle von Amazon hätte ein XAI-Verfahren vermutlich das Geschlecht als relevant für viele Entscheidungen markiert. Das Ungleichgewicht zwischen Männern und Frauen in den Trainingsdaten wäre aufgefallen und hätte korrigiert werden können, zum Beispiel in dem man das Merkmal »Geschlecht« vom Training ausschließt.

Die Vorbereitungen auf den späteren Einsatz von XAI sollten also schon jetzt getroffen werden. So können ähnliche Vorfälle bereits im Vorhinein vermieden werden. Darüber hinaus soll besseres Verständnis darüber, wie KI lernt, dafür sorgen, bessere Modelle zu erstellen und Fehler in der Anwendung von KI vorzubeugen. Dass KI anders lernt und wahrnimmt als wir Menschen, ist nämlich seit geraumer Zeit hinreichend geklärt (vgl. etwa Wichmann et al.: Animal detection in natural scenes: Critical features revisited).

XAI kann also als Wegbereiter der KI in Bereiche, wo reine »Black Box«-KI aufgrund ihrer Intransparenz nicht angewendet werden kann, gesehen werden. So können auch in solchen Fällen die Potenziale der KI ausgeschöpft werden. XAI als vermeintlich fortgeschrittenes Thema wird somit zur grundlegenden Voraussetzung von KI – und sollte folgerichtig ähnlich konsequent wie KI gefördert und verwendet werden.

Das Projekt kann über die folgende Webseite angesehen werden:

Weiterführendes von ÖFIT:

Das Kompetenzzentrum Öffentliche IT widmet sich im Rahmen seiner Trendübersicht den aktuellen Digitaltrends. Hier erhalten Sie die wichtigsten Informationen zu verschiedenen Themen und Begriffen auf einen Blick.

Was sind die wesentlichen Innovationsfelder der öffentlichen IT? Wo bieten sich Chancen, wo lauern Risiken? Um diese Fragen zu beantworten, haben wir in einer Datenanalyse fünf wesentliche Innovationsfelder der öffentlichen IT identifiziert.

Innovationsfelder Öffentlicher IT 2019/2020

Silke Cuno, Jan Gottschick, Dorian Grosch, Jan Dennis Gumz, Karoline Krenn, Nicole Opiela, Jens Tiemann, Mike Weber, Christian Welzel, Armin Wolf (2019)

Berlin: Fraunhofer FOKUS: Kompetenzzentrum Öffentliche IT

Veröffentlicht: 30.07.2021